tokenembedding

tokenembedding、tokenembedding的作用

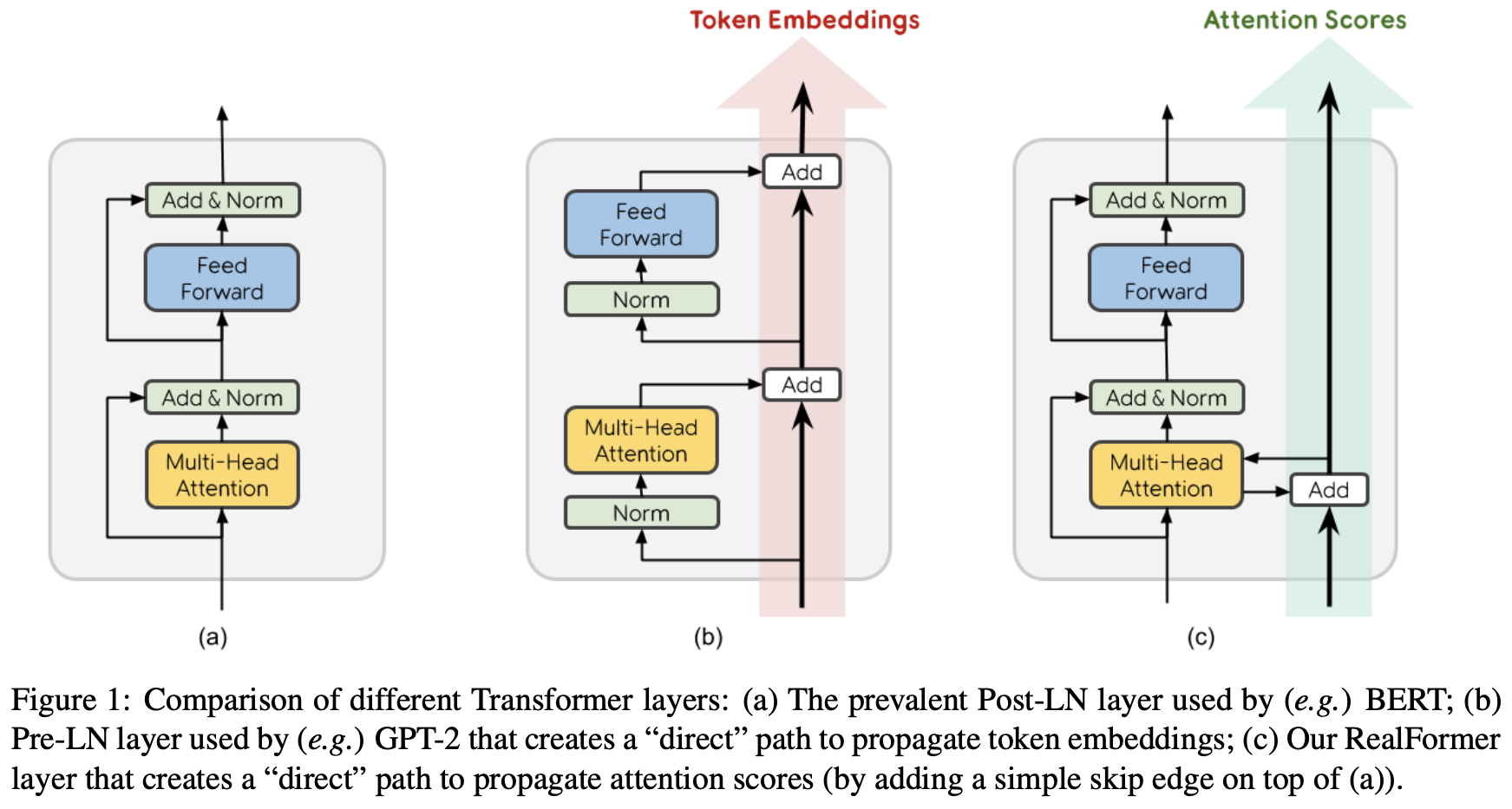

ALBERT认为,tokenembedding是没有上下文依赖的表述,而隐藏层的输出值不仅包括了词本身的意思还包括一些上下文信息,因此应该让HE,所以ALBERT的词向量的维度是小于encoder输出值维度的在NLP任务中,通常词典都会很大,embeddingmatrix的大小。如下图所示,我们

日期 2024-04-10 阅 39 tokenembedding

1