您现在的位置是:首页 > telegeram安卓下载 > 正文

telegeram安卓下载

tokenembedding、tokenembedding的作用

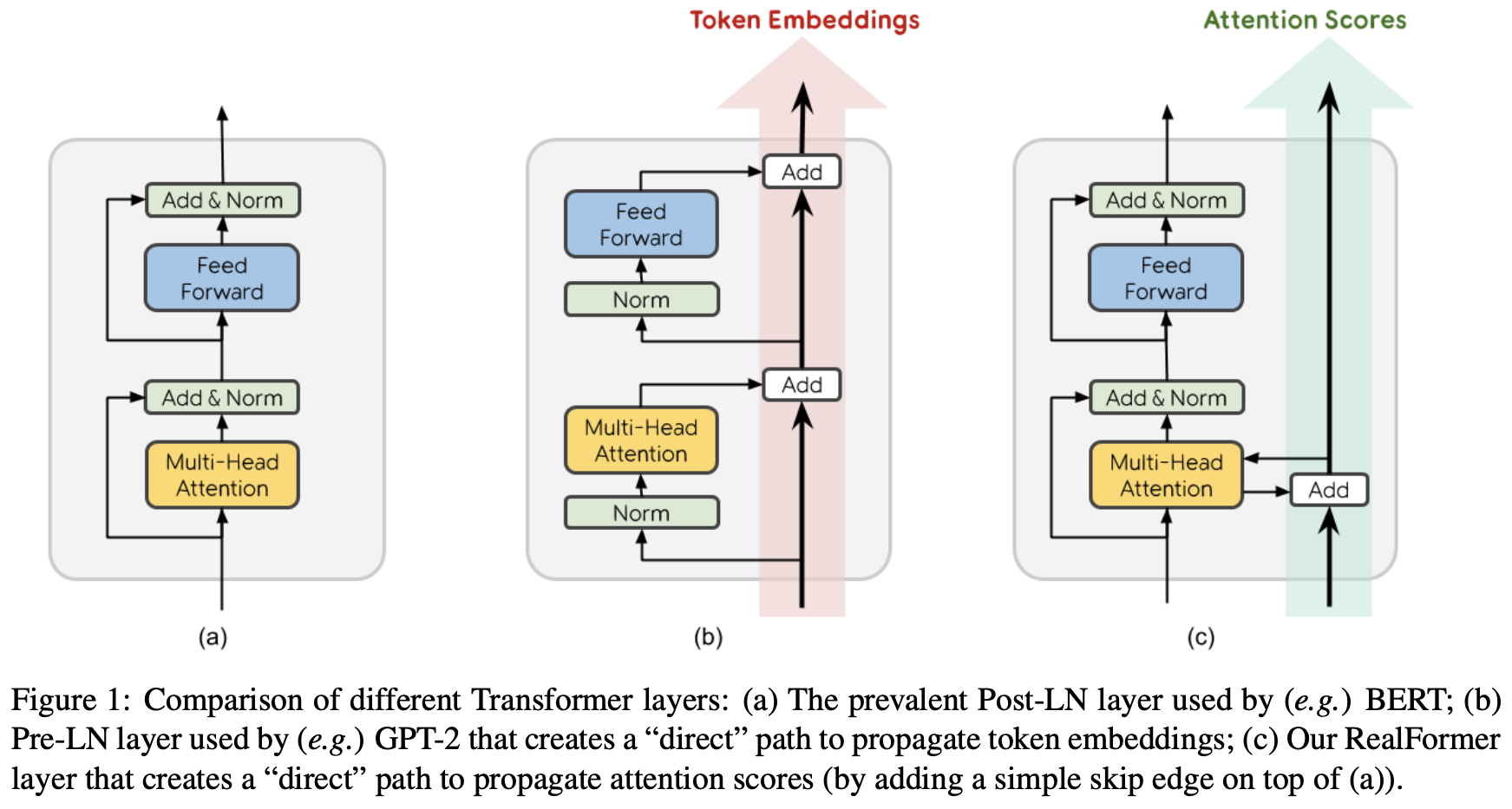

ALBERT认为,tokenembedding是没有上下文依赖的表述,而隐藏层的输出值不仅包括了词本身的意思还包括一些上下文信息,因此应该让HE,所以ALBERT的词向量的维度是小于encoder输

ALBERT认为,token embedding是没有上下文依赖的表述,而隐藏层的输出值不仅包括了词本身的意思还包括一些上下文信息,因此应该让HE,所以ALBERT的词向量的维度是小于encoder输出值维度的在NLP任务中,通常词典都会很大,embedding matrix的大小。

如下图所示,我们定义输入的embedding为 ,BERT最终输出的 CLS 的embedding为 ,最终输出的第 个token的embedding为 我们有理由相信一个深度双向模型比lefttoright模型和lefttoright和righttoleft简单连接的模型的效果更加强大。

bert的词嵌入由三个嵌入token embeddingsegment embedding,和position embedding叠加而成 这个过程跟以往的RNNs没什么区别,比如给定一个句子 第一步是先将其标记化 然后是数字化,将每个标记映射到语料词汇表中的唯一整数编号 接下。

#8195#8195Token Embedding 是对词向量进行编码原始的输入是batch,seq_len经过 Token Embedding 后数据的维度为batch,seq_len,d_model#8195#8195在BERT中Token Embedding的内部计算流程是初始化一个。