telegeram中文版官网下载

网页爬虫编写方法:爬虫爬取网页的代码

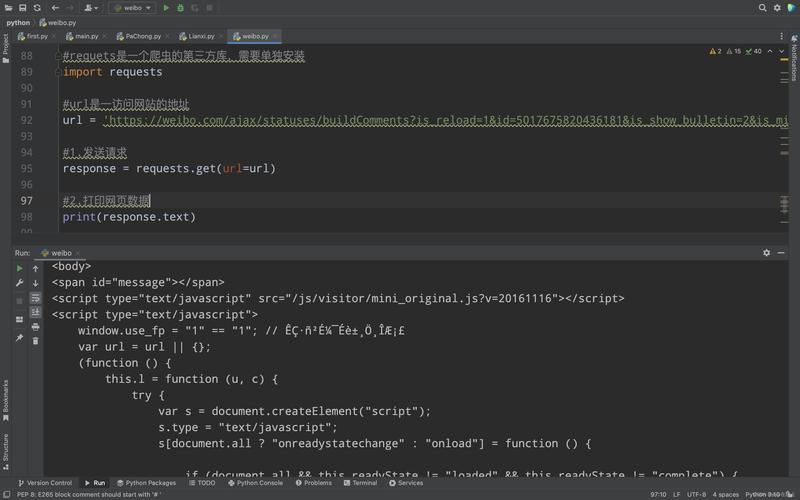

1、google project网站有一个项目叫做sinawler,就是专门的新浪微博爬虫,用来抓取微博内容网站上不去,这个你懂的不过可以百度一下“python编写的新浪微博爬虫现在的登陆方法见新的一则微博“,可以找到一个参考的源码,他是用python2写的如果用python3写,其实可以使用urllibrequest模拟构建一个带;1首先,打开原网页,如下,这里假设要爬取的字段包括昵称内容好笑数和评论数2然后针对以上网页结构,我们就可以直接编写爬虫代码,解析网页并提取出我们需要的数据了,测试代码如下,非常简单,主要用到requests+BeautifulSoup组合,其中requests用于获取网页源码,BeautifulSoup用于解析网页提取数据动态网;可以从获取网页内容解析HTML提取数据等方面进行实践5 深入学习随着对Python爬虫的熟悉程度提高,可以学习更高级的爬虫技术,如动态网页爬取反爬虫策略应对等八爪鱼采集器是一款功能全面操作简单适用范围广泛的互联网数据采集器,可以帮助用户快速获取所需的数据了解更多数据采集的方法和技巧;2打开要爬取的网页,例如豆瓣 Top250 的 URL 是 ,同时按 option+command+i 或者 Windows 系统的 ctrl+shift+i 进入开发者模式,看到网页 HTML,点击 Web Scraper 图标进入爬虫页面 3创建爬虫点击 create new sitemap 和 create sitemap,随便输入 sitemap name,如。

2、1这里以爬取rank上的PM25数据为例,都是规整的表格数据,如下2新建一个excel文件并打开,依次点击菜单栏的“数据”“自网站”,如下3接着在弹出的窗口输入上面的网页链接地址,点击“转到”按钮,就会自动打开网页,如下4最后,我们点击右下角的“导入”按钮,就能将网页中的表格数据;点击创建 sitemap,完成爬虫创建创建爬虫后,我们需要设置选择器来定义要抓取的数据首先,点击“Add new selector”按钮,选择器编辑页面会自动打开通过选择器,我们可以指定爬虫抓取的 HTML 元素对于豆瓣 Top250,我们需要抓取电影排名名称评分和简短影评在创建了容器选择器后,我们需要进一步在;使用Java语言实现一个网页爬虫,首先需要选择合适的爬虫框架,比如Heritrix或WebSPHINX这些框架提供了丰富的功能和良好的扩展性,可以满足不同需求实现网页爬虫时,需要遵循robotstxt文件的规则,尊重网站的爬虫政策同时,还需要处理好线程同步和异常处理,确保爬虫的稳定运行在实际应用中,Web爬虫不仅可;3网页下载爬虫主要技术点2模拟登录后,便可下载目标网页html了知乎爬虫基于;Python快速上手的7大技巧 Python快速上手爬虫的7大技巧 1基本抓取网页 get方法 post方法 2使用代理IP 在开发爬虫过程中经常会遇到IP被封掉的情况,这时就需要用到 代理IP在urllib 2包中有Proxy Handler类, 通过此类可以设置代理 访问网页,如下代码片段3Cookies处理 cookies是某些网站为了辨别。

3、在学习python的过程中,学会获取网站的内容是我们必须要掌握的知识和技能,今天就分享一下爬虫的基本流程,只有了解了过程,我们再慢慢一步步的去掌握它所包含的知识Python网络爬虫大概需要以下几个步骤一获取网站的地址有些网站的网址十分的好获取,显而易见,但是有些网址需要我们在浏览器中经过分析;6 运行采集任务确认设置无误后,可以启动采集任务,让八爪鱼开始采集小说网站上的数据7 等待采集完成八爪鱼将根据设置的规则自动抓取页面上的小说数据,并将其保存到本地或导出到指定的文件格式八爪鱼采集器提供了丰富的教程和帮助文档,可以帮助您更深入地了解数据采集的方法和技巧请前往官网;6 运行采集任务确认设置无误后,可以启动采集任务,让八爪鱼开始爬取网页数据7 等待爬取完成八爪鱼将根据设置的规则自动抓取页面上的数据,并将其保存到本地或导出到指定的数据库等八爪鱼采集器提供了丰富的功能和灵活的设置,可以满足不同网页数据爬取的需求了解更多数据爬取的方法和技巧。

4、36#39 response = requestsgeturl=url, params=params, headers=headerspage_text = responsetext with openquot周杰伦htmlquot, quotwquot, encoding=quotutf8quot as ffwritepage_textprintquotokquot在进行网络爬虫操作时,合理使用Requests库的get函数,可以有效地实现网页抓取和数据提取;用C语言编写网络爬虫需要以下基础知识1 C语言基础了解C语言的基本语法数据类型流程控制等基本知识2 网络编程基础了解网络编程的基本概念和原理,包括TCPIP协议Socket编程等3 HTML基础了解HTML的基本结构和标签,以便能够解析和提取网页内容4。

5、isDepthAcceptable是否达到指定的深度上限爬虫一般采取广度优先的方式一些网站会构建爬虫陷阱自动生成一些无效链接使爬虫陷入死循环,采用深度限制加以避免 if doWeHavePermissionToVisitcrawlerUrl !isUrlAlreadyVisitedcrawlerUrl isDepthAcceptablecrawlerUrl nextUrl = crawler;具体操作时,首先需要安装pyspider和PhantomJS,然后配置pyspider项目,指定使用PhantomJS作为浏览器在编写爬虫代码时,可以使用pyspider提供的API来模拟点击操作,实现自动加载更多内容例如,可以编写一个任务,模拟点击“加载更多”按钮,然后解析返回的HTML内容,提取所需的数据使用这种方式,不仅可以获取到;可能需要使用Selenium等工具来模拟浏览器行为在进行爬虫开发时,请务必遵守目标网站的robotstxt文件规则,避免对网站造成不必要的负担同时,合理设置请求间隔,避免短时间内大量请求导致服务器压力过大希望上述方法对你有所帮助,如果有具体网站需要统计,可以尝试按照上述步骤编写Python脚本进行实现。